В наше время борьба с поддельными новостями и информацией является очень важной задачей, особенно в связи со скоростью распространения данных. Поэтому Adobe объявила, что её специалисты Ричард Чжан (Richard Zhang) и Оливер Ван объединили усилия с сотрудниками Калифорнийского университета в Беркли Шеном-Ю Ваном, доктором Эндрю Оуэнсом и профессором Алексеем А. Эфросом с целью создать систему на основе ИИ, способную с высокой точностью обнаруживать манипуляции с лицами на изображениях, которые были отредактированы с помощью программного обеспечения вроде Photoshop.

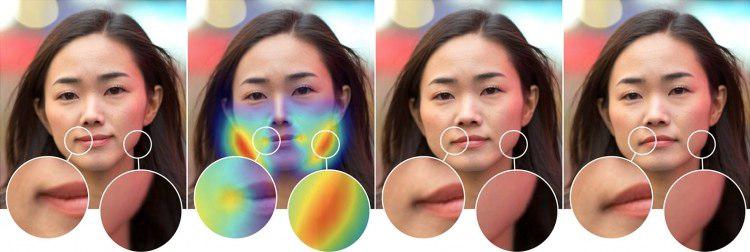

Проект Adobe, спонсируемый DARPA по программе MediFor, находится пока на раннем этапе. Он заключается в обучении сверхточной нейронной сети (CNN), — одной из форм глубинного обучения, — которая в рамках исследования оказалась способна распознавать лица, подвергшиеся изменениям в результате манипуляций. Исследователи создали обширный обучающий набор изображений, написав скрипт Photoshop, использующий фильтр Face Aware Liquify на тысячах случайных фотографий из Интернета.

Интересно, что созданный в Adobe метод оказался куда более совершенным, чем человеческий глаз. Если люди в среднем определяли манипуляции с лицами с помощью популярного метода Face Aware Liquify лишь в 53 % случаев (то есть чуть больше, чем случайный выбор), то алгоритм на основе ИИ — в 99 %. Это весьма достойный результат.