Предыдущую статью мы закончили на относительно современных видеокартах, которые уже использовали универсальные шейдеры. На этом я хотел закончить цикл, но по многочисленным просьбам все же доведу его до конца, так что сегодня поговорим уже о современных видеокартах, вплоть до решений с поддержкой DirectX 12 (изначально я планировал сделать одну статью с описанием видеокарт вплоть до Pascal и Vega, но итоговый объем материала — порядка 10 листов А4 — вынудил меня разбить ее на две).

Чип Nvidia G92 — кручу, верчу, запутать хочу

Уже с самого выпуска чипа в 2007 году Nvidia решила запутать пользователей: казалось бы, новый чип — новая линейка. А вот и нет — изначально видеокарты на нем принадлежали 8000 серии. Чип выпускался по более тонкому техпроцессу — 65 нм, имел только 112 потоковых процессоров (против 128 у 8800 Ultra), а шина памяти была урезана до 256 бит. Также появилась поддержка нового стандарта PCIe 2.0 (который был вдвое быстрее 1.0 — до 8 ГБ/с), при этом совместимость с 1.0 никуда не делась. Частота GPU первой топовой видеокарты на этом чипе — 8800 GTS — была 650 МГц, и в итоге это нивелировало разницу в потоковых процессорах с G80, так что эта видеокарта выступала на уровне 8800 GTX и Ultra.

Еще одним важным изменением в чипе G92 можно считать поддержку CUDA (да, она есть и в G80, но появилась она все же во времена G92, поэтому я и говорю о ней тут). Это программно-аппаратная архитектура, которая позволяет проводить некоторые вычисления на видеокарте, причем, с учетом того, что GPU уже давно мощнее CPU, ускорение может быть достаточно серьезным. Изначально вычисления проводились с 32-битной точностью (64-битная появилась в следующем чипе, GT200, и производительность при работе с такой точностью была серьезно хуже). Графический процессор реализовывал аппаратную многопоточность, что позволяло задействовать все вычислительные блоки — это и привело к идее переложить на плечи видеокарты физику. Таким образом появился PhysX — правда, только в следующем поколении чипов от Nvidia.

Nvidia на этом не остановились — в начале 2008 года вышла 9800 GTX, которая представляла собой банально разогнанную 8800 GTS. И чтобы добить пользователей, в середине 2008 года вышла 9800 GTX+, которая отличалась от обычной версии тем, что чип G92 теперь выпускался по 55 нм техпроцессу. Казалось бы — куда дальше-то, чип уже и так в двух линейках есть. Но Nvidia это не остановило, и этот же самый чип появился и в 200 линейке видеокарт — а именно в GTS 250. Правда, эта видеокарта уже позиционировалась как решение среднего уровня.

Ну а топовой видеокартой в линейке стала 9800 GX2. Думаете, что она представляла две 9800? Почти — почему-то Nvidia использовала две 8800 GTS 512 МБ, а по внешнему виду видеокарта напоминала 7900 GX2 — то есть по сути две соединенные платы, на каждой по одному чипу. Разумеется, прирост от такой связки был не везде, но где он был — выводил 9800 GX2 в лидеры.

Nvidia GT200 — количественные изменения

В июне 2008 года Nvidia представила новый топовый чип — GT200 (логичнее было бы назвать его G100, но у Nvidia своя нумерация — чипы 100 серии появились... позже). И как я уже писал выше, изменения были количественными: из-за появления второго поколения унифицированных шейдеров число потоковых процессоров возросло вдвое. Чип имел 32 ROP (растровые блоки) и 80 текстурных блоков, техпроцесс был 65 нм (при этом в этой же линейке были решения и на 55 нм, и даже на 40), а шина памяти была увеличена до 512 бит. Увы — с поддержкой API было все хуже, чем у конкурента от AMD — RV670: поддерживался только DirectX 10 и Shader Model 4.0, но в дальнейшем Nvidia все же сделала поддержку DirectX 10.1, так что поиграть на GTX 280 в GTA 5 все же можно. К слову, этот топовый чип имел частоту в 600 МГц и комплектовался GDDR3 памятью, которой могло быть до 1 ГБ.

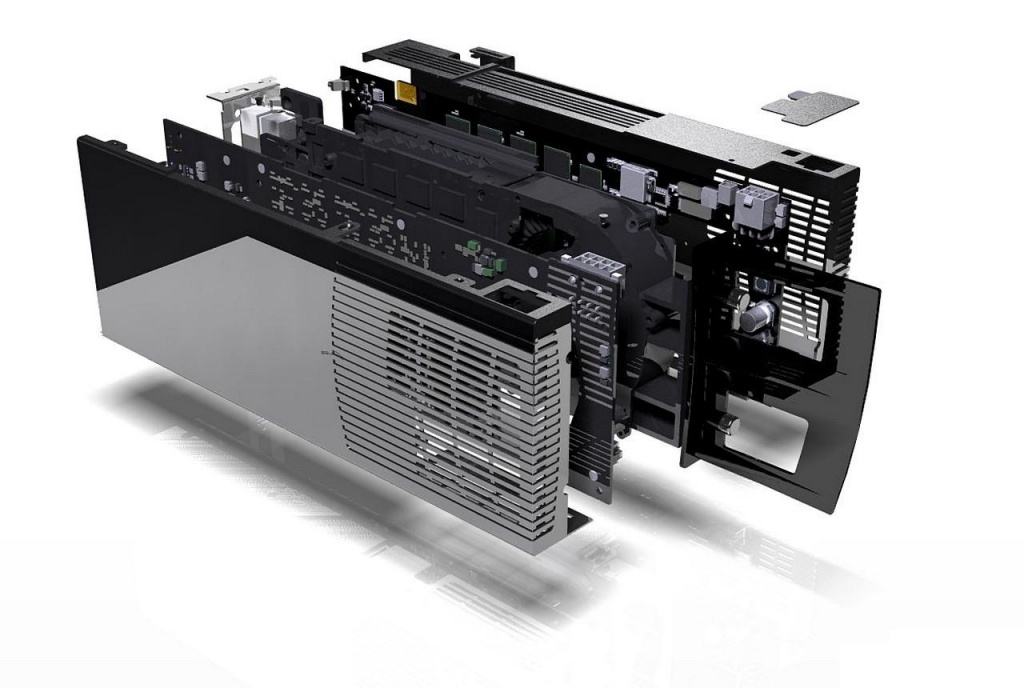

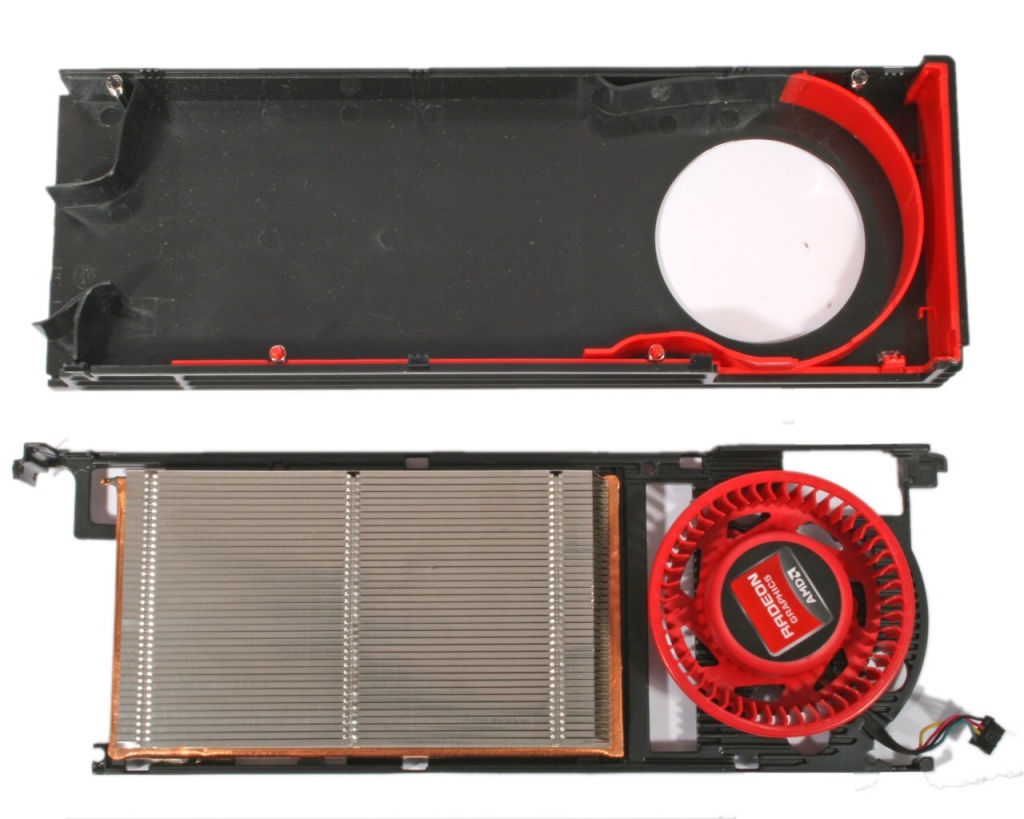

Через год, уже в середине 2009, Nvidia выпустила «ремастер» 280 видеокарты — GTX 285. Чип GT200 в ней был построен по более тонкому 55 нм техпроцессу, что позволило поднять частоту на 10% — до 650 МГц. Однако конкурировать с двухчиповым топом от «красных», Radeon 4870X2 (о нем поговорим ниже), 285ая не могла, так что Nvidia так же пришлось выпустить двухчиповую видеокарту — GTX295. Эту карточку можно смело называть одной из самых проблемных: во-первых, одна референсная турбина была не способна охладить два чипа GT200 на частотах от 285ой (то есть 650 МГц). Более того — она была не способна работать даже на частотах 280ой — 600 МГц, так что в итоге частоту оставили на уровне 576 МГц. Второе урезание — это количество шейдеров: каждый чип в 295ой использовал лишь 216 штук против 240 возможных (то есть по сути видеокарта представляла собой две GTX 260 в SLI). Увы — даже это не помогло: видеокарта моментально забивалась пылью и грелась до 100 градусов. В итоге Nvidia была вынуждена выпустить новую ревизию — GTX 295 Rev. B, где была изменена компоновка чипов: если в Rev. A каждый чип располагался на свой плате, и оба они охлаждались одним радиатором, то у новой ревизии оба чипа были на одной плате и имели разные радиаторы, а вертушка была в центре — это позволило серьезно снизить нагрев и упростить обслуживание видеокарты:

Ну и вторая проблема, которая моментально вылезла при использовании высоких настроек в играх — нехватка памяти: каждый из урезанных чипов GT200 комплектовался 896 МБ, и с учетом того, что SLI память не суммирует, памяти у топовый видеокарты оказалось даже меньше, чем у GTX 285. Разумеется, в играх через пару лет это негативно сказалось на производительности.

Линейка GeForce 100 — всеми забытый OEM сегмент

Наверное, многим приходила в голову мысль — а куда делась 100 линейка видеокарт? Была 7000, 8000, 9000, а потом сразу 200, 300 и т.д.? Нет, разумеется нет — такая линейка действительно была представлена весной 2009 года, и базировалась она на различных чипах G9x. О них мало кто слышал по одной простой причине — это была OEM-линейка, то есть видеокарты из нее ставились лишь в готовые решения. По факту это была переименованная 9000 линейка, из улучшений — кое-где чипы были построены по более тонкому техпроцессу, кое-где были выше частоты. В общем — ничего интересного в них не было, самая топовая видеокарта в ней — GTS 150 — была по сути обычной GTS 250, что есть middle-сегмент.

Но что-то мы заговорились про «зеленых» — пора бы уже перейти к их конкуренту, AMD.

AMD RV770 и RV790 — обновленный RV670

Как я уже писал в конце предыдущей статьи — с появлением универсальной шейдерной архитектуры нововведения почти полностью перешли в количественную область. И RV770, представленный в середине 2008 года, исключением не стал — более тонкий техпроцесс, 55 нм, шина памяти так и осталась 256-битной. хотя сама память стала уже точно современной — GDDR5. В самой топовой видеокарте — Radeon HD 4870 — было 800 вычислительных процессоров, 16 ROP и 40 текстурных блоков. Частота ядра была на уровне 750 МГц, а у памяти — рекордные на тот момент 3600 МГц. Но все же всего этого было мало для того, чтобы конкурировать с топовой на тот момент GTX 280 — HD 4870 показывала производительность на уровне GTX 260, то есть была middle-end.

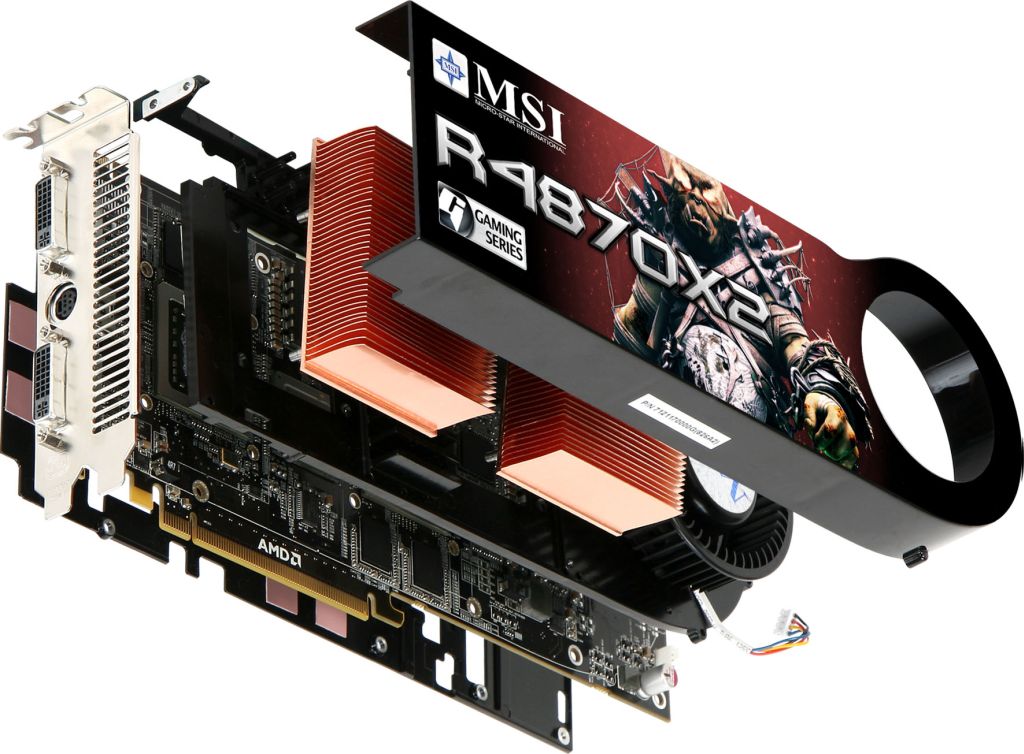

А вот самой топовой стала видеокарта HD 4870X2 — двухголовое решение на базе 3870X2, где все отличия заключались в чуть более высоких частотах и поддержке интерфейса Sideport, который ускорял взаимодействие чипов друг с другом. Однако между 4870 и 4870X2 образовался большой провал — его AMD заполнила несколько обновленным чипом RV790, который имел более высокие частоты (до 900 МГц). Также AMD провела ребалансировку внутренних таймингов, а контроллер памяти получил функцию Burst Read (режим пакетной передачи данных). Но самым основным изменением стало добавление так называемого «развязывающего кольца» из конденсаторов, которое снижало уровень шумов и улучшало качество сигнала. В итоге видеокарта HD 4890 на этом чипе уже могла конкурировать с GTX 280 и 285.

Линейка Nvidia Geforce 300 — еще один OEM сегмент

По непонятным причинам Nvidia рвалась в OEM сегмент — тут никто не использовал видеокарты для игр, поэтому предыдущей OEM-линейке, GT 100, выпущенной буквально годом раньше, более чем хватало для офисных задач. Но все же линейка была выпущена, и, думаю, лучше всего она запомнилась владельцам MacBook 2010 года — именно там в Air использовалась 320М, а в Pro — 330M. Владельцы же ПК про десктопные видеокарты 300 линейки слышали мало, что вполне логично — они базировались на старых чипах GT200 и G9x, а самая топовая из них — GT 340 — являлась банальным переименованием GT 240, то есть была видеокартой младшего ценового сегмента.

AMD R800 — как RV790, только мощнее

На этот раз AMD обогнала Nvidia в выпуске первых 40 нм видеокарт, причем достаточно серьезно — на несколько месяцев. Архитектурно различий между новым R800 и старым RV790 почти не было — стало вдвое больше потоковых процессоров — 1600, вдвое больше текстурных блоков — 80. Все это оказалось возможным благодаря уменьшению техпроцесса до 40 нм — в итоге при увеличении вычислительных блоков вдвое площадь чипа выросла всего на треть, так что видеокарта HD 5870 на этом чипе оказалась на уровне GTX 280.

Из интересных мультимедийных возможностей — появилась технология AMD Eyefinity, которая позволяла подключать к одной видеокарте до 6 мониторов, и выводить на их все картинку. Также эти чипы обзавелись поддержкой нового тогда API — DirectX 11. И проблемы с ним были схожими с текущими с DX12 — вроде бы в теории все должно быть быстрее, а на практике оказывается в лучшем случае так же, как и со старым API.

Ну и завершая линейку 40 нм чипов от AMD, перейдем в 6000 линейке, вышедшей в конце 2010 года. Они были построены на базе архитектуры VLIW4 (ее фишка — одна инструкция процессора содержит несколько операций, которые должны выполняться параллельно. Дли видеокарт, где вычислительных процессоров тысяча — просто идеальная архитектура, правда если софт будет нормально написан). Количество вычислительных процессоров несколько уменьшилось — до 1536, а вот число текстурных блоков выросло до 96. Ширина шины памяти составляет 256 бит, а ее объем у топовой HD 6970 мог составлять 2 ГБ. Увы — до топовой на тот момент GTX 580 она не дотянулась, оказываясь на уровне middle-end GTX 570.

Ну а уже о совсем новых видеокартах, основанных на архитектуре GCN (для AMD) и Fermi и новее (для Nvidia) мы поговорим в точно заключительной статье цикла об истории видеокарт.